La inteligencia artificial ha dado un salto revolucionario con los modelos de lenguaje de gran escala, o LLMs (Large Language Models), que transforman industrias y moldean nuevas formas de interactuar con la tecnología. Sin embargo, en esta revolución tecnológica, una disputa fundamental se cierne entre los modelos de código abierto y código cerrado. Dos ejemplos representativos de esta división son LLAMA, el LLM de código abierto desarrollado por Meta, y GPT, de OpenAI, un modelo de código cerrado que lidera el desarrollo de IA avanzada en la actualidad. Esta contienda tiene implicaciones profundas, no solo para la innovación en inteligencia artificial, sino también para la ética, la seguridad y el futuro del conocimiento compartido.

Modelos de Lenguaje de Código Abierto: Libertad y Transparencia

Los modelos de código abierto, como LLAMA, permiten que cualquier desarrollador acceda al código fuente del modelo, brindando libertad para modificar, personalizar y adaptar el sistema según sus necesidades específicas. Esta apertura ofrece una serie de ventajas críticas. En primer lugar, fomenta la transparencia, ya que los usuarios pueden inspeccionar el código, comprender su funcionamiento y detectar posibles sesgos o fallas. Este nivel de acceso resulta crucial en áreas donde la precisión y la equidad son esenciales, como en el ámbito de la salud, la justicia y la educación.

Además, el código abierto promueve una comunidad activa de desarrolladores que colaboran para mejorar el modelo, creando una red de conocimiento compartido que impulsa la innovación de manera más rápida y democrática. Esta colaboración ha dado lugar a avances rápidos en LLMs que, de otro modo, podrían haber tomado años bajo estructuras corporativas más cerradas. Para muchos, los modelos de código abierto representan el espíritu de una inteligencia artificial inclusiva y accesible.

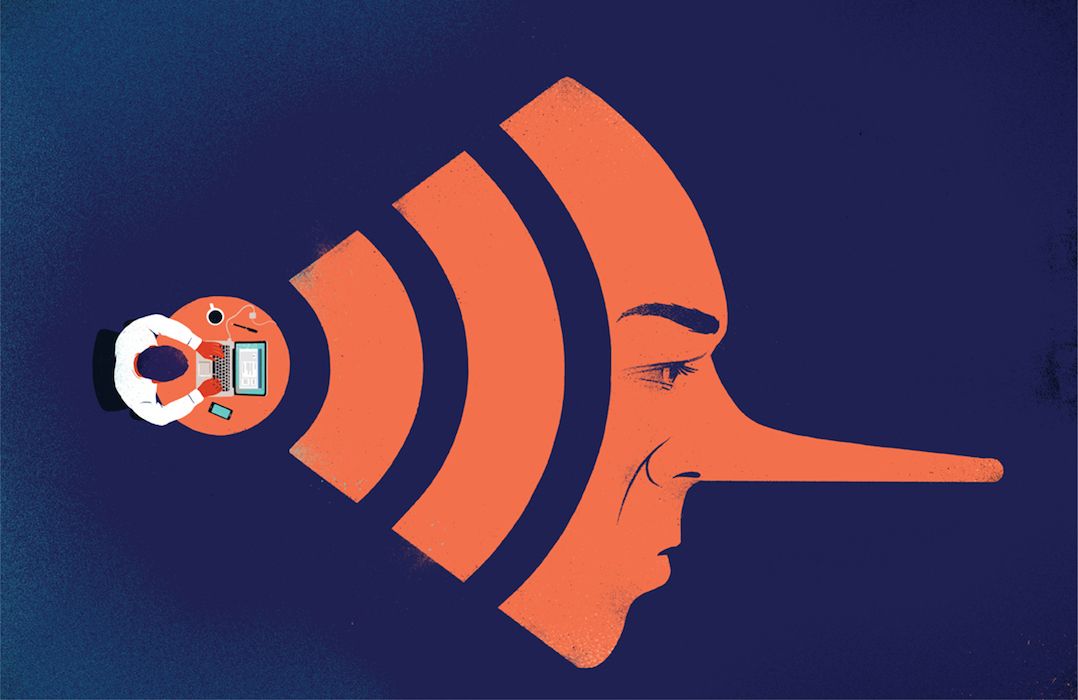

Sin embargo, los modelos de lenguaje de código abierto también plantean desafíos. La libertad de uso y modificación puede facilitar la creación de aplicaciones dañinas o irresponsables que no siempre cuentan con un marco de control adecuado. Si bien existen licencias y normativas, el acceso sin restricciones puede ser un riesgo si estos modelos caen en manos equivocadas o se utilizan sin supervisión ética.

LLMs de Código Cerrado: Precisión y Control

En el otro extremo, los modelos de código cerrado, como GPT-4 de OpenAI, se desarrollan en un entorno cerrado y controlado. Esto permite a las empresas imponer restricciones de uso que limitan las aplicaciones potencialmente dañinas, mejorando el control sobre la implementación y asegurando, hasta cierto punto, que los LLMs se utilicen de manera ética y segura. OpenAI, por ejemplo, invierte grandes recursos en la investigación de alineación y seguridad para garantizar que su IA sea precisa, segura y cumpla con estándares de calidad y control de sesgos.

Los modelos de código cerrado también suelen tener la ventaja de contar con financiamiento sólido y equipos altamente especializados. Esto les permite avanzar en tecnologías punteras y desarrollar características avanzadas de los LLMs. Sin embargo, el costo de este control es la falta de transparencia. Los usuarios externos no pueden inspeccionar el código ni verificar cómo se toman decisiones dentro del modelo, lo que crea una caja negra en áreas críticas donde la transparencia y la confianza son esenciales.

Además, al ser desarrollos patentados, estos modelos de código cerrado se encuentran mayormente bajo el control de un número limitado de empresas, lo cual puede crear monopolios de conocimiento y poder en la IA. Los críticos sostienen que la centralización de la IA en manos de unas pocas corporaciones limita la diversidad de ideas y la inclusión de voces alternativas, una cuestión cada vez más importante a medida que los LLMs impactan la vida cotidiana.

- Las fábricas oscuras de China: el fin del trabajo industrial como lo conocíamos - 6 marzo, 2026

- Latam-GPT: se lanza en Chile la primera IA latinoamericana - 13 febrero, 2026

- 3 hongos que pueden mejorar tu salud - 1 febrero, 2026