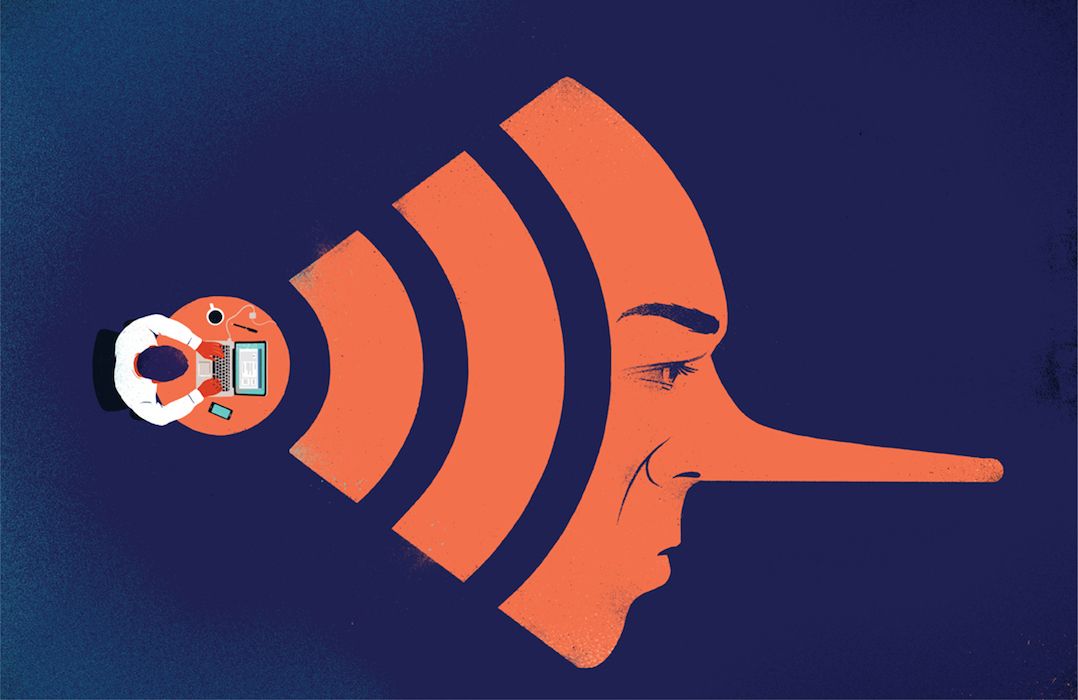

En el debate sobre la regulación de la inteligencia artificial, existe un aspecto que a menudo se pasa por alto: la opacidad. Es decir, la imposibilidad de comprender qué ocurre exactamente dentro de los sistemas de IA más avanzados. A diferencia del software tradicional, donde cada instrucción es trazable y entendible, los modelos de lenguaje y aprendizaje profundo construyen patrones, asociaciones y decisiones a partir de procesos que ni sus propios creadores pueden explicar del todo.

Esta falta de interpretabilidad no es un detalle técnico, sino un problema estructural. Implica que hoy están en funcionamiento sistemas capaces de producir diagnósticos médicos, decisiones financieras o hasta discursos políticos sin que nadie pueda explicar del todo por qué lo hacen o cuáles son sus criterios internos. En otras palabras: hemos creado herramientas potentes sin manual.

Desde Algoritmo venimos insistiendo en que regular la IA no significa detener la innovación, sino encauzarla con sentido humano. En este punto, la transparencia debe ser un principio rector. No podemos permitir que sistemas que impactan directamente en la vida de las personas operen como cajas negras. Necesitamos desarrollar mecanismos de interpretabilidad, marcos legales que exijan trazabilidad y auditorías independientes que permitan escrutar los códigos y procesos de estas herramientas.

Implica que hoy están en funcionamiento sistemas capaces de producir diagnósticos médicos, decisiones financieras o hasta discursos políticos sin que nadie pueda explicar del todo por qué lo hacen o cuáles son sus criterios internos. En otras palabras: hemos creado herramientas potentes sin manual.

Imaginar una resonancia magnética para la IA puede parecer exagerado, pero es una buena metáfora: necesitamos ver dentro para cuidar fuera. No alcanza con saber que un sistema funciona; debemos saber cómo y por qué. De lo contrario, no se trata de inteligencia artificial, sino de poder artificial: invisible, no elegido y sin responsabilidad.

Los Estados tienen un rol insustituible en esta tarea. Deberían establecer organismos especializados que fiscalicen el funcionamiento interno de los modelos más potentes, exigir reportes públicos de explicabilidad, promover estándares de gobernanza algorítmica y fomentar consorcios científicos interinstitucionales que trabajen sobre la interpretabilidad. Regular la IA no es solo prevenir el daño: es garantizar que las decisiones automatizadas respeten los principios democráticos y los derechos fundamentales.

La regulación de la IA debe incorporar esta dimensión crítica de la opacidad. Si no entendemos lo que hemos creado, tarde o temprano esos sistemas van a terminar tomando decisiones en las que ya no seremos parte. Y eso, en cualquier idioma, se llama rendirse sin pelear.

Es músico y escritor. Se me ha perdido una canción (2011), Mis canciones (2014) y Seré canción entonces… (2018) son sus tres discos. Ha publicado también la novela Una tumba sin nombre (2012) y el ensayo Renta Básica Universal: Por qué y cómo terminar para siempre con la pobreza. Es Licenciado en Ciencias de la Comunicación (Universidad Austral, Argentina), Master en Acción Política y Participación Ciudadana (Universidad del Rey Juan Carlos, España) y Diplomado en Gestión Pública (Instituto Tecnológico de Monterrey, México). Es fundador, director y editor de la Revista Algoritmo.

- Temu, Mercado Libre y la hipocresía del diseño digital - 31 enero, 2026

- Corea del Sur: el primer país en regular la IA - 24 enero, 2026

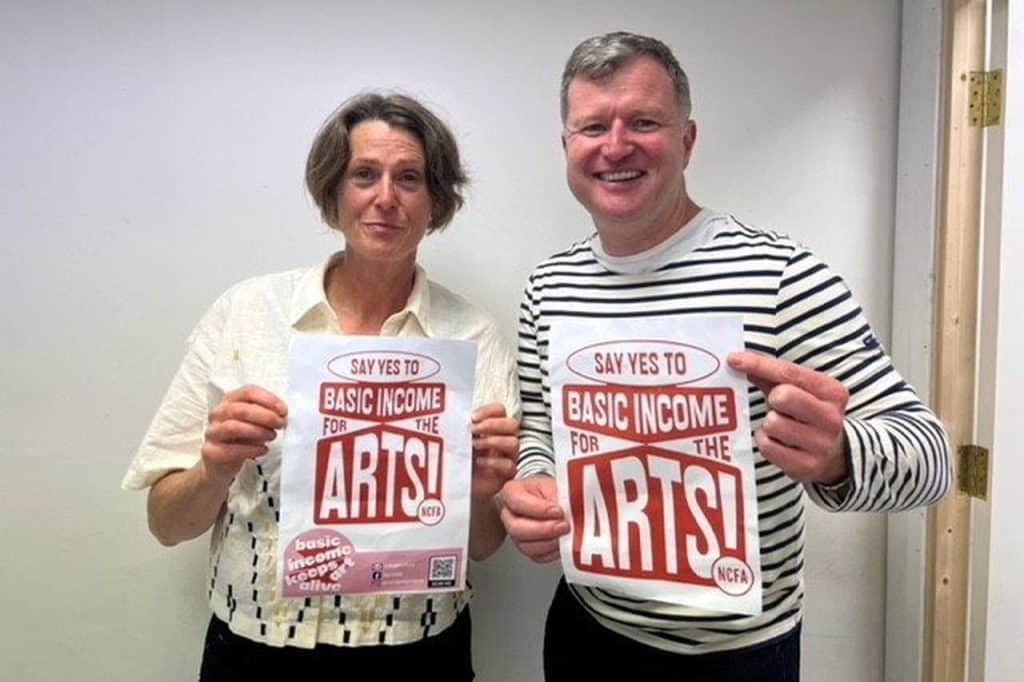

- Ingreso básico universal para artistas en Irlanda - 24 octubre, 2025